什么是robots文件

robots是一个文本格式(txt)的文件,它一般在网站的根目录中,它是一个告诉搜索引擎蜘蛛抓取内容的协议文件

我博客的robots文件地址:qingheseo.com/robots.txt

robots的作用

robots.txt的作用是:告诉搜索引擎哪些页面可以抓取,哪些页面不允许抓取

并且设置好robots文件后,它还能屏蔽部分搜索引擎蜘蛛的抓取

在robots中,我们也可以设置网站的站点地图(sitemap),设置后每次蜘蛛来时,都会访问一次我们的站点地图

robots.txt中的常见规则表达

1.User-agent

User-agent – 指定搜索引擎爬虫,可以设置多个user-agent,用来针对不同的蜘蛛设置不同的规则

例如:

- User-agent: *表示所有蜘蛛

- User-agent: Googlebot 表示只允许谷歌蜘蛛抓取

2.Allow/Disallow

Allow表示允许抓取的目录

Disallow表示不允许抓取的目录

例如:

- Allow: /public/ 允许爬取/public/目录

- Disallow: /private/ 禁止爬取/private/目录

- Disallow: / 禁止爬取所有内容

3.Crawl-delay

Crawl-delay用于表示告诉搜索引擎蜘蛛抓取的时间间隔

例如:

- Crawl-delay: 10 表示搜索引擎蜘蛛每次抓取间隔10秒

4.Sitemap

sitemap 表示网站的站点地图所在位置

例如:

Sitemap:https://www.qingheseo.com/wp-sitemap.xml

这个地址是WordPress自带的站点地图地址,由于我目前没使用第三方插件,只专注写博客了

所以。。这个地址就是我当前网站的站点地图

5.通配符使用

通配符指的是:*,用来表示所有

例如:

- Disallow: /*.pdf$ 禁止访问所有PDF文件

- Disallow: /*?*禁止带参数的动态URL

robots文件的优化方法

robots文件通常放在网站的根目录下,

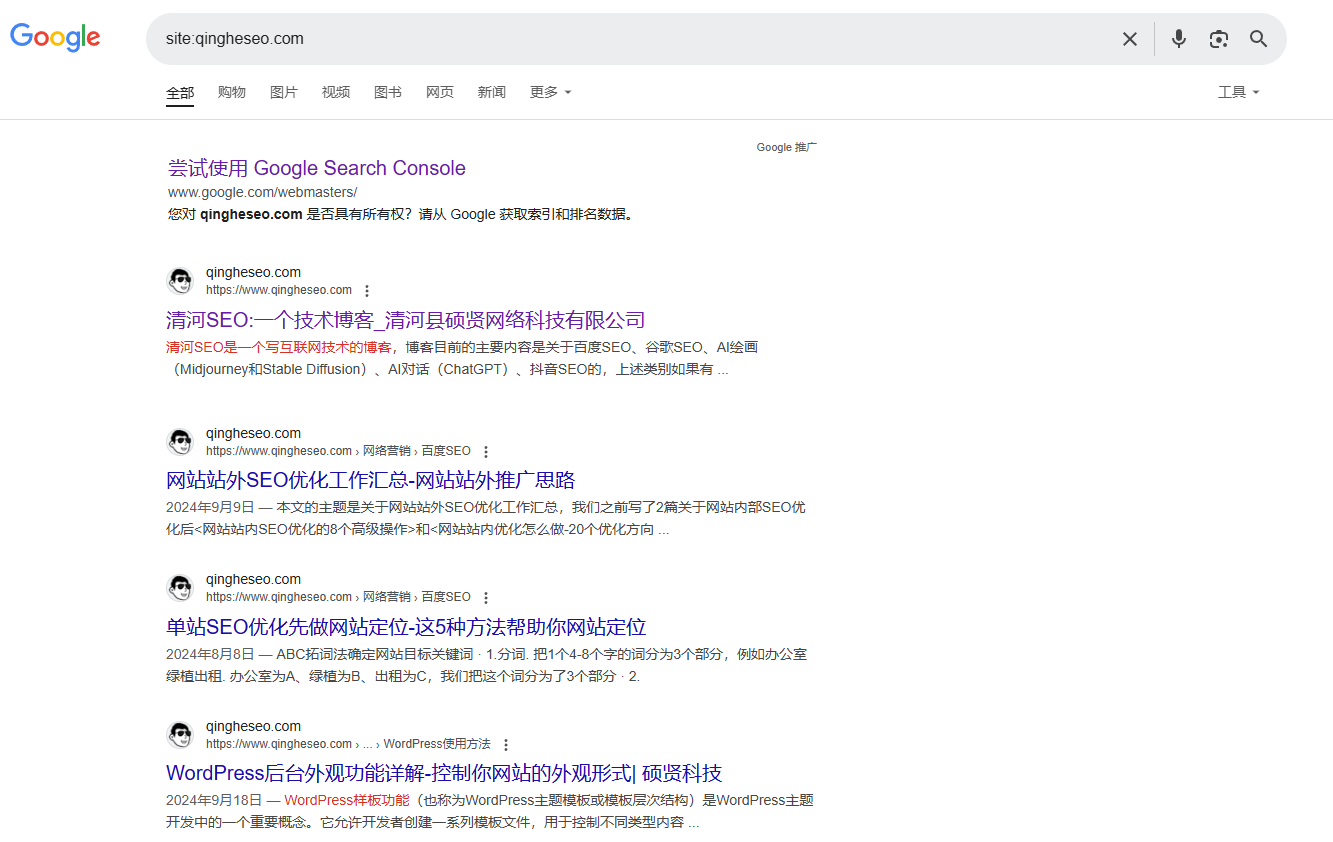

可以看到这是我博客的robots的文件内容

robots常见的屏蔽内容

1.动态链接

首先,动态链接不利于SEO,因为动态链接参数过多,且由于是动态链接,其URL经常发生变化,所以要把网站的链接格式改成静态链接或伪静态链接

这篇《做Google SEO时网站URL的优化方法》中提到了WordPress网站如何修固定链接样式

2.搜索结果页面

在WordPress网站中都带有搜索的功能,有时候用户会在网站上搜索无用的关键词,进而会产生垃圾页面

所以,我们可以使用Disallow: /search 来告诉蜘蛛,后缀是/search结尾的统统不允许抓取

3.附件或视频地址

网站上可能有很多的附件地址或视频所在的URL,建议把这些文件所在的URL屏蔽掉

4.网站后台地址

我们都知道,网站后台地址是很重要的

当有不良居心的人进入到你的网站后台,对你的网站、文章、页面、数据、个人知名度都是毁灭性的打击

WordPress网站可以修改网站后台的登录地址,也可以用插件实现登陆地址的个性化变动

我们也可以在robots中写一个关于屏蔽网站后台登录地址,格式为:Disallow:/wp-login/或Diasllow:/wp-admin/

注意:可以不用写完你的后台登陆地址或后台管理界面,只需写前3位

搜索引擎看到后,就会自动不抓取这些开头及后续的URL

5.重复收录的无用链接

有一些内容较少且无用的页面链接,我们也可以把它们放到robots的协议中

也可以查看网站日志,看蜘蛛的抓取内容,从而确认蜘蛛是否抓取了无用链接,从而屏蔽掉

硕贤科技

硕贤科技

评论留言